Cara Kerja Search Engine Google Dengan Freshbot dan Deepbot

Daftar Isi

Robot ini secara fisik terlihat seperti serangkaian super komputer yang membuka halaman web dan menelusuri apa saja yang ada di halaman web tersebut. Baik konten onpage maupun linknya. Tujuan utama dari Google membuat robot ini adalah untuk memudahkan mendownload sebanyak mungkin halaman web di internet ke dalam sistem mereka sehingga mereka bisa mengadakan perhitungan yang sangat kompleks dengan super cepat.

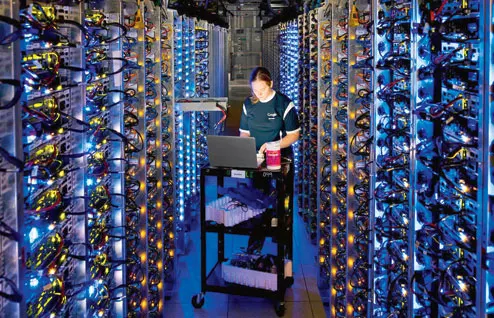

Jadi bisa anda bayangkan sebesar apa server Google yang dipakai untuk menyimpan puluhan triliun halaman web yang tersedia di internet saat ini? Kurang lebih seperti inilah server data dari google, yang dipakai untuk menyimpan data dari internet.

|

| pegawai Google melakukan perbaikan server yang overheat |

|

| Server Google di Iowa |

Pada saat anda melakukan optimasi mesin pencari atau SEO, maka anda harus memahami siklus kerja dari robot Google, agar anda tahu kapan hasil kerja anda memperlihatkan hasil. Untuk itu anda harus berkenalan dengan 2 robot Google, yaitu freshbot dan deepbot.

Apa itu Freshbot?

Ini adalah robot yang berfungsi untuk mengindeks konten baru yang ada pada sebuah website. Robot ini bekerja menurut frekuensi update dari sebuah website. Semakin sering website tersebut melakukan update, maka freshbot akan semakin meningkatkankan tingkat perayapannya pada website tersebut.Ini yang membuat ada website yang saat melakukan update membutuhkan waktu berhari-hari untuk terindeks. Tapi ada juga website yang hanya membutuhkan waktu sedetik saja untuk terindeks. Semakin tinggi tingkat update dari website anda dengan konten yang fresh, dan unik, maka Google akan memandang bahwa website anda memang serius dikelola.

Jadi saat anda melakukan SEO atau search engine optimization, waktu pengindeksan ini sangat penting. Banyak website yang waktu pengindeksannya sangat lama menderita kerugian karena kontennya dicuri oleh website yang mempunyai waktu indeks yang lebih cepat. Akibatnya dalam sistem Google justru pembuat aslinya yang menjadi duplikat, karena terindeks belakangan.

Untuk menghindari hal ini sebaiknya anda tidak mengaktifkan dulu feed dari blog anda untuk mencegah pencurian konten. Anda bisa mengaktifkan feed dari blog anda saat tingkat perayapan dari blog anda sudah lebih cepat.

Apa itu Deepbot?

Deepbot adalah robot yang merayapi internet sebulan sekali untuk mengindeks perubahan karena update pada sebuah halaman web. Jika anda bertanya apa saja yang diindeks oleh deepbot, maka itu mencakup semuanya. Ini semacam mendownload ulang halaman dan menghapus data halaman yang lama. Anda bisa melihat data terbaru yang didownload oleh deepbot ini dari cache yang disimpan Google.Jadi jika anda melakukan update dalam proses SEO yang anda lakukan, maka anda harus menunggu deepbot mampir ke halaman web tersebut untuk melihat hasil dari penerapan update tersebut. Hal yang sama berlaku juga untuk backlink, karena backlink saudara menempel di halaman web orang lain. Jadi harus menunggu deepbot mampir di halaman web tersebut.

Jadi jangan cepat mengamuk karena memasang backlink tapi website saudara tidak mengalami perubahan peringkat di hasil pencarian google. Semua itu harus menunggu deepbot beraksi. Bahkan anda perlu tahu bahwa halaman web yang sudah sangat tua memerlukan waktu yang lebih lama, bahkan ada backlink yang baru terindeks setelah satu tahun. Kasus seperti ini memang sangat jarang terjadi, tapi bisa saja terjadi.

Mengatur Pergerakan Robot Google Di Halaman Web Anda

Google adalah salah satu perusahaan yang menghormati anda selaku pemilik website. Jika anda melarang robot menjelajahi suatu halaman web, maka robot tersebut tidak akan menyentuh halaman web anda. Cara untuk melakukan ini sangat sederhana yaitu dengan mengatur robots.txt di halaman web anda.Cara mengatur robots.txt dalam merayapi halaman web kita ini sangat perlu untuk diperhatikan karena bisa sangat menentukan keberhasilan atau kegagalan dari proses SEO yang kita lakukan. Anda perlu tahu halaman-halaman apa saja yang perlu diblokir dan halaman apa saja yang jangan sampai terblokir.

Biasanya halaman yang perlu kita blokir adalah halaman yang bisa menimbulkan duplikat konten. Biasanya ini terjadi pada website-website yang menyediakan beberapa versi tampilan seperti HTML, print view, dan juga pdf.

Ada beberapa website yang juga memblokir halaman label, atau sub dari halaman index, untuk mencegah duplikat title tag. Padahal halaman-halaman ini membantu aliran poin. Seharusnya halaman seperti ini tidak diblokir. Seharusnya title tag yang dimodifikasi agar tidak menghasilkan duplikat.

Posting Komentar